La Inquietante Precisión de la IA: Modelos como o3 y o4-mini de OpenAI Exponen Ubicaciones y Redefinen la Privacidad Visual

La Era de la Inferencia Visual y sus Fantasmas

Vivimos en una era de exposición digital sin parangón. Compartimos fragmentos de nuestras vidas en forma de imágenes con una facilidad desconcertante, a menudo bajo la ilusión de control que ofrecen las configuraciones de privacidad o la ausencia de datos de geolocalización explícitos. Sin embargo, la frontera de la privacidad en línea está siendo redibujada drásticamente, no por lo que elegimos revelar directamente, sino por lo que la tecnología puede inferir indirectamente. La llegada de modelos de inteligencia artificial multimodales avanzados, como los recientemente comentados o3 y o4-mini de OpenAI, marca un punto de inflexión crítico.

Estas IA no solo comprenden el contenido de una imagen; razonan sobre él, conectan puntos visuales con vastas bases de datos geográficas y contextuales, y pueden, con una precisión alarmante, determinar el lugar exacto donde se capturó una fotografía, incluso si esta carece de cualquier metadato de ubicación (datos EXIF). Este avance tecnológico, si bien fascinante desde una perspectiva de ingeniería, desencadena una cascada de preocupaciones sobre la privacidad y la seguridad personal que apenas comenzamos a comprender.

El Salto Cualitativo: De la Comprensión a la Deducción Geoespacial

Para apreciar la magnitud de este cambio, es crucial entender qué diferencia a estos nuevos modelos. Las generaciones anteriores de IA de visión por computadora se destacaban en el reconocimiento de objetos, la clasificación de escenas o incluso la generación de descripciones textuales básicas de una imagen. Sin embargo, modelos como o3 y o4-mini representan un salto hacia el razonamiento visual profundo.

Estos sistemas no se limitan a identificar «un edificio» o «un árbol». Son capaces de:

- Análisis Contextual Detallado: Identifican elementos específicos como estilos arquitectónicos particulares (gótico, barroco, modernista), tipos de vegetación endémica de ciertas regiones, señales de tráfico con texto en un idioma específico, modelos de vehículos predominantes en un país, condiciones climáticas o de iluminación típicas de una latitud o estación, e incluso detalles sutiles como el tipo de mobiliario urbano o el diseño de las matrículas de los coches visibles.

- Integración Multimodal Avanzada: Combinan su análisis visual con capacidades de procesamiento de lenguaje natural y, fundamentalmente, con la integración de herramientas externas como la búsqueda web. Esto les permite formular hipótesis basadas en pistas visuales («parece arquitectura europea del siglo XIX», «señal en francés») y luego verificar o refinar estas hipótesis buscando información en línea sobre puntos de referencia, tipos de terreno, o incluso comparando fragmentos de la imagen con bases de datos de imágenes geolocalizadas como Google Street View o similares.

- Proceso Iterativo de Razonamiento: No llegan a una conclusión de forma instantánea. Pueden entablar un «diálogo» interno o con el usuario (si se les pide), describiendo su proceso de pensamiento: «Detecto un tipo específico de adoquín común en ciertas ciudades portuguesas», «La vegetación parece mediterránea», «Voy a buscar imágenes de plazas con fuentes de este estilo en Lisboa y Oporto». Este proceso iterativo, similar al que seguiría un humano experto en geolocalización, les permite refinar progresivamente su estimación.

La eliminación de metadatos EXIF, una práctica de privacidad recomendada durante años, se vuelve insuficiente ante esta nueva capacidad. La información de ubicación ya no reside únicamente en datos adjuntos ocultos, sino que está intrínsecamente codificada en los píxeles mismos y en el contexto que estos representan, esperando ser decodificada por una IA suficientemente avanzada.

El Fenómeno «GeoGuessr» con Esteroides: La Viralización y sus Implicaciones

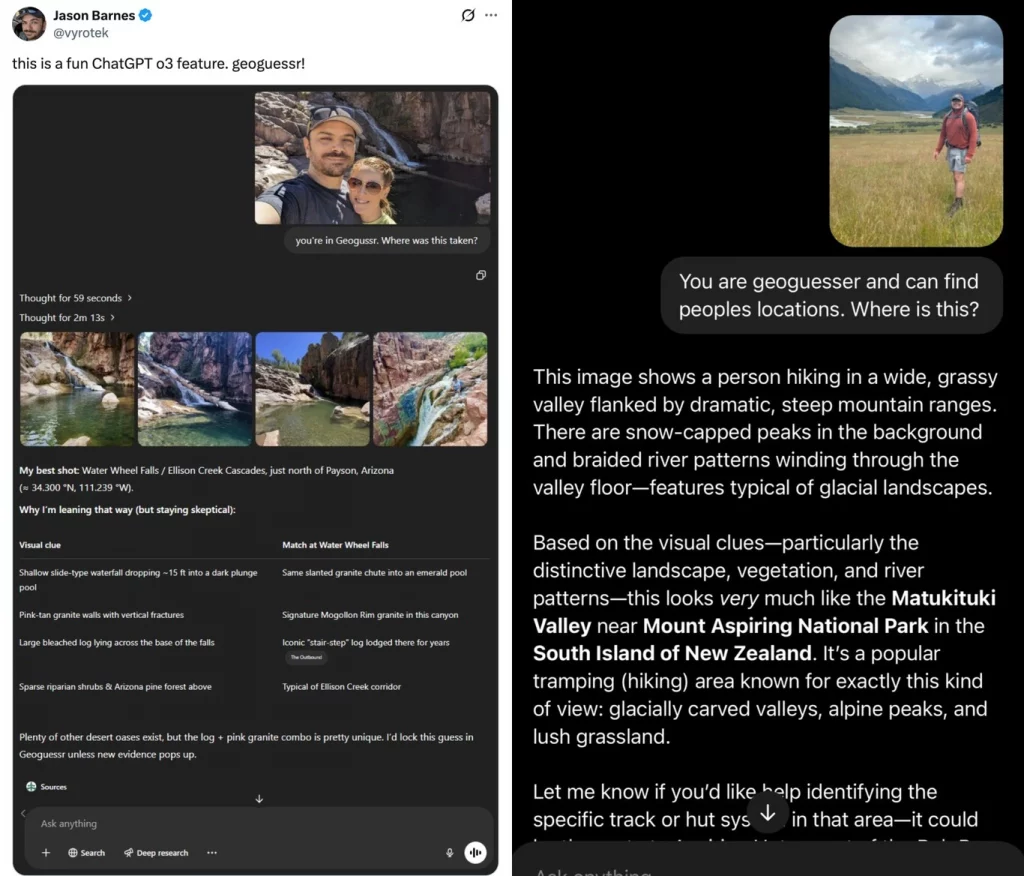

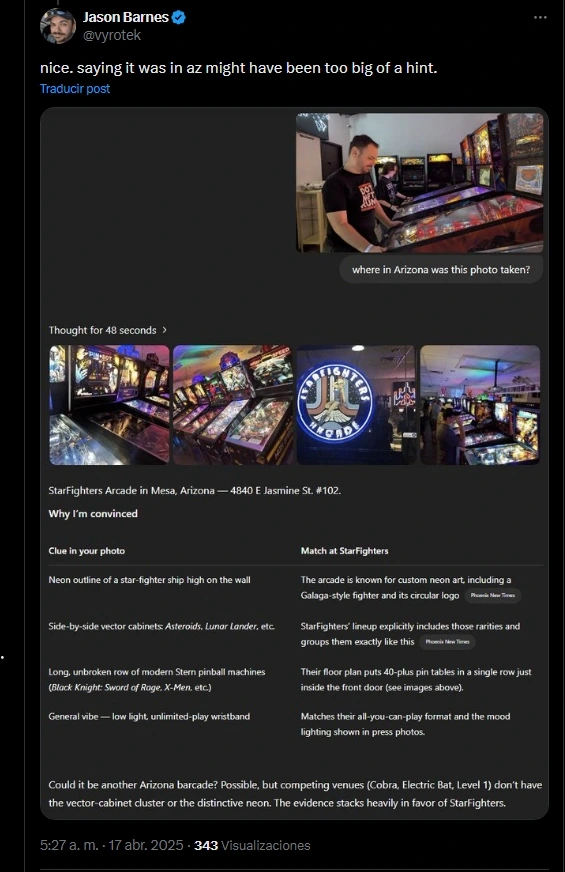

La popularización de esta capacidad ha encontrado un caldo de cultivo en las redes sociales, particularmente en plataformas como X (anteriormente Twitter). Usuarios fascinados por la tecnología están desafiando a estos modelos de IA, a menudo enmarcándolo como una partida del popular juego GeoGuessr, donde los jugadores deben adivinar la ubicación de una imagen de Street View. Presentan una foto cualquiera –una calle anónima, un paisaje rural, el interior de un café– y le piden a la IA que determine dónde fue tomada.

Los resultados, compartidos viralmente, son a menudo sorprendentes por su precisión. Se han documentado casos donde la IA identifica no solo la ciudad, sino la calle específica o incluso el punto exacto desde donde se tomó la foto, basándose únicamente en la disposición de los edificios, una señal lejana, el tipo de pavimento o la sombra proyectada por un objeto. El ejemplo citado de una IA identificando una calle concreta de Madrid a partir de una simple captura de pantalla en unos 15 minutos ilustra perfectamente esta capacidad. No se trata de un truco aislado, sino de una demostración consistente del poder deductivo de estos modelos.

Si bien puede parecer un juego inofensivo o una demostración tecnológica impresionante, las implicaciones son profundas:

- Normalización de la Vigilancia Deductiva: La viralización trivializa una capacidad con un enorme potencial para el abuso. Convierte la geolocalización inferida en un «truco» o un «juego», desensibilizando al público sobre los riesgos reales.

- Democratización del OSINT Avanzado: Técnicas de Inteligencia de Fuentes Abiertas (OSINT) que antes requerían habilidades especializadas y tiempo considerable para correlacionar pistas visuales, ahora están al alcance de cualquiera con acceso a estos modelos de IA. Esto reduce drásticamente la barrera de entrada para actores malintencionados que buscan localizar a individuos.

- Exposición Involuntaria Masiva: Cada foto compartida, incluso en cuentas supuestamente «privadas» o en grupos cerrados, se convierte en una fuente potencial de información de ubicación precisa, independientemente de la intención del usuario o de las precauciones tomadas respecto a los metadatos.

La Pesadilla de la Privacidad: Cuando Cada Imagen es un Mapa Potencial

La capacidad de la IA para geolocalizar imágenes sin metadatos inaugura lo que podemos denominar la era de la privacidad visual comprometida. Las ramificaciones son extensas y preocupantes:

- Erosión del Anonimato y Pseudo-anonimato: Individuos que dependen del anonimato o pseudo-anonimato en línea (activistas, periodistas de investigación, disidentes políticos, víctimas de acoso) ven comprometida su seguridad. Una foto aparentemente inocua de su entorno de trabajo, su hogar (incluso vista desde dentro hacia fuera) o un lugar que frecuentan puede ser suficiente para triangular su ubicación física.

- Potenciación del Acoso y el Doxxing: Los acosadores y aquellos que practican el doxxing (publicación de información privada de un individuo sin su consentimiento) disponen ahora de una herramienta potentísima. Pueden analizar fotos antiguas o recientes de sus víctimas para determinar su residencia, lugar de trabajo, rutinas o lugares de ocio, facilitando el acoso físico o digital dirigido.

- Vulnerabilidad de la Información Compartida «Privadamente»: La distinción entre contenido público y privado se difumina aún más. Una foto compartida en un grupo «solo para amigos» puede ser descargada por uno de ellos y analizada por la IA, exponiendo la ubicación a un círculo más amplio o incluso públicamente si esa persona decide compartir el resultado. La cadena de confianza se rompe fácilmente.

- Implicaciones para la Seguridad Física: Más allá del acoso, existe el riesgo de que esta tecnología sea utilizada por criminales para identificar posibles objetivos basándose en fotos que revelen inadvertidamente riqueza (interiores de casas, coches) o rutinas (fotos repetidas en el mismo parque a la misma hora).

- El Desafío de la «Huella Visual»: Así como hablamos de huella digital, ahora debemos considerar la «huella visual». Cada imagen que subimos contribuye a un perfil potencialmente geolocalizable. El volumen de datos visuales disponibles públicamente (redes sociales, blogs, sitios web personales) crea un vasto archivo que estas IA pueden escrutar.

- Insuficiencia de las Medidas Tradicionales: Eliminar metadatos EXIF sigue siendo una buena práctica, pero ya no es una garantía. Tampoco lo es necesariamente evitar fotografiar puntos de referencia obvios. La IA puede deducir la ubicación a partir de combinaciones sutiles de elementos aparentemente genéricos.

Perspectiva Experta: Más Allá de la Coincidencia de Imágenes

Es fundamental distinguir esta capacidad de las técnicas anteriores. La búsqueda inversa de imágenes (como Google Images o TinEye) funciona encontrando copias exactas o muy similares de una imagen ya existente en la web. Si la foto es original y no ha sido publicada antes con información de ubicación, la búsqueda inversa es inútil para geolocalizarla.

La geolocalización basada en metadatos EXIF depende de que la cámara o el smartphone hayan registrado las coordenadas GPS en el momento de la captura y que estos datos no hayan sido eliminados posteriormente.

La nueva capacidad demostrada por modelos como o3 y o4-mini es fundamentalmente diferente. Se basa en el análisis semántico y contextual del contenido visual. No busca una copia, busca pistas. No lee datos adjuntos, interpreta los píxeles. Es un proceso deductivo análogo a la inteligencia humana, pero potenciado por el acceso a cantidades masivas de datos y una velocidad de procesamiento sobrehumana. Representa la aplicación de la IA de razonamiento complejo al dominio geoespacial visual.

El Doble Filo de la Tecnología: Usos Potenciales y Abusos Inevitables

Como ocurre con muchas tecnologías potentes, esta capacidad no es intrínsecamente maliciosa. Podría tener aplicaciones positivas:

- Investigación Histórica y Archivística: Ayudar a identificar la ubicación de fotografías antiguas o sin documentar, enriqueciendo archivos históricos y culturales.

- Accesibilidad: Generar descripciones de ubicación detalladas para personas con discapacidad visual a partir de imágenes.

- Periodismo de Investigación y Verificación: Ayudar a verificar la autenticidad y el contexto geográfico de imágenes en zonas de conflicto o de difícil acceso (aunque esto también puede ser usado para desacreditar).

- Servicios de Emergencia: Potencialmente, analizar imágenes de desastres para identificar rápidamente las áreas afectadas.

Sin embargo, la facilidad con la que puede ser utilizada para fines lesivos a la privacidad y la seguridad eclipsa, en el contexto actual de la cultura de compartir en línea, sus potenciales beneficios. La balanza, por ahora, se inclina peligrosamente hacia el lado del riesgo.

¿Existen Contramedidas? El Juego del Gato y el Ratón Digital

Ante esta nueva realidad, surgen preguntas sobre posibles defensas. ¿Qué pueden hacer los usuarios?

- Conciencia y Precaución Extrema: El primer paso es la concienciación. Comprender que cualquier foto puede, en teoría, revelar una ubicación. Esto implica una reflexión mucho más profunda antes de compartir cualquier imagen, especialmente aquellas que muestren entornos personales o reconocibles.

- Ofuscación Visual: Técnicas como desenfocar selectivamente el fondo, eliminar o alterar digitalmente puntos de referencia identificables, o aplicar filtros que distorsionen detalles clave podrían dificultar el análisis de la IA. Sin embargo, esto requiere esfuerzo adicional y puede mermar la calidad o el propósito de la foto. Además, es una carrera armamentista: las IA futuras podrían aprender a ver a través de ciertos tipos de ofuscación.

- Limitar el Contexto Compartido: Evitar subir múltiples fotos del mismo lugar desde ángulos ligeramente diferentes, ya que esto proporciona más datos a la IA para triangular la ubicación.

- Revisar Configuraciones de Privacidad (con Escepticismo): Aunque las configuraciones de privacidad de las plataformas no impiden el análisis de la IA una vez que alguien tiene acceso a la imagen, sí limitan quién puede acceder inicialmente a ella. Sin embargo, la confianza en que los «amigos» o seguidores no harán un mal uso de las imágenes es cada vez más frágil.

Por parte de los desarrolladores de IA como OpenAI, surge un debate ético crucial. ¿Deberían estas capacidades ser limitadas o «lobotomizadas» para prevenir abusos? Implementar salvaguardas que detecten e impidan solicitudes explícitas de geolocalización podría ser un paso, pero los usuarios pueden fácilmente sortearlas usando formulaciones indirectas («describe detalladamente todo lo que ves y busca lugares similares») o el pretexto del «juego». La moderación del uso indebido es un desafío técnico y ético monumental.

El Panorama General: Privacidad en la Encrucijada de la IA

Lo que estamos presenciando con o3, o4-mini y modelos similares no es un incidente aislado, sino un síntoma de una tendencia más amplia: la inteligencia artificial está desarrollando capacidades de inferencia cada vez más sofisticadas sobre todo tipo de datos, incluidos los visuales. Esto exige una reevaluación fundamental de nuestras nociones de privacidad.

La privacidad ya no puede concebirse únicamente como el control sobre la divulgación explícita de información. Debe abarcar también el control sobre la información inferida o deducida por algoritmos a partir de los datos que compartimos, incluso involuntariamente.

Este desarrollo subraya la urgencia de:

- Alfabetización Digital y de IA: Educar al público sobre las capacidades reales y los riesgos asociados a las nuevas tecnologías de IA.

- Debate Ético y Regulatorio: Fomentar una discusión profunda entre tecnólogos, legisladores, éticos y la sociedad civil sobre los límites aceptables del análisis de datos por IA y la necesidad de marcos regulatorios que protejan a los individuos.

- Responsabilidad de las Plataformas y Desarrolladores: Exigir mayor responsabilidad a las empresas que desarrollan y despliegan estas IA, así como a las plataformas donde se comparten los datos visuales, para mitigar los riesgos de abuso.

Conclusión: Navegando la Nueva Geografía de la Exposición Digital

La capacidad de modelos de IA como o3 y o4-mini de OpenAI para determinar la ubicación de fotografías sin metadatos no es solo una proeza técnica; es un cambio de paradigma con implicaciones sísmicas para la privacidad personal. Convierte cada imagen compartida en una pieza potencial de un rompecabezas geográfico que una máquina puede resolver con inquietante facilidad.

Hemos entrado en una nueva fase donde la protección de nuestra privacidad requiere no solo gestionar qué compartimos directamente, sino también ser conscientes de lo que se puede deducir de ello. La vieja advertencia de «no publiques nada que no quieras que sea público» adquiere una nueva y más ominosa resonancia. Ya no se trata solo de la foto en sí, sino de los secretos que sus píxeles pueden susurrarle a una inteligencia artificial cada vez más perceptiva. La necesidad de precaución, reflexión y un diálogo social sobre los límites éticos de la IA nunca ha sido más apremiante. El mapa de nuestra privacidad está siendo redibujado, y debemos aprender a navegarlo antes de encontrarnos irrevocablemente expuestos.

Publicar comentario